За последние десять лет энергопотребление центральных процессоров, графических ускорителей, памяти и специализированных чипов выросло примерно на 200%. Это означает не только рост затрат на электроэнергию, но и резкое увеличение тепловыделения, которое требуется эффективно отводить. Более мощные компоненты – центральные и графические процессоры, память и т. д., – выделяют больше локализованного тепла, которое не рассеивается, ограничивает производительность и может стать причиной перегрева и возгорания.

Почему так происходит? Все дело в Эффекте Джоуля: электрический ток протекает через проводник с сопротивлением, эта электрическая энергия преобразуется в тепло. Чем больше потребляется энергии, тем больше выделяется тепла. Борьба с теплом, выделяемым из-за возросших потребностей в энергии, стала проблемой для многих организаций. В том числе для тех, кто стремится сбалансировать технологические достижения со своими обязательствами в области ESG (environmental, social, governance/природа, общество, управление).

Это касается не только высокотехнологичных компаний. Например, в банковском секторе постоянно растут нагрузки на ИТ-системы из-за увеличения клиентской базы, расширения списка предоставляемых услуг, развития мобильных приложений. Чтобы поддерживать высокий уровень сервиса, банки вынуждены наращивать инфраструктуру и интегрировать новые решения для обработки транзакций, анализа данных и киберзащиты. В условиях, когда плотность вычислительных ресурсов в стойках постоянно увеличивается, именно системы охлаждения становятся одним из ключевых факторов, определяющих надёжность и производительность всей инфраструктуры. Для руководителей компаний это не просто техническая проблема — от эффективности охлаждения зависит скорость вывода новых продуктов на рынок, бесперебойная работа сервисов и конкурентоспособность компании.

Чаще всего ЦОДы — ключевые объекты потребления энергии, и необходимо выделять значительную площадь для физического охлаждения его компонентов для бесперебойной работы. При воздушном охлаждении чем больше площадь поверхности радиатора, тем лучше его производительность. В итоге это приводит к увеличению размеров систем по высоте, что снижает объем вычислительной мощности, который можно разместить в ЦОДе. Это означает меньшую вычислительную мощность при увеличении энергопотребления!

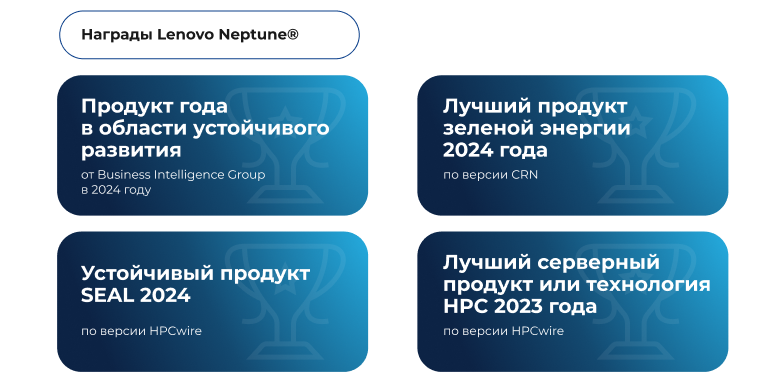

Жидкость способна поглощать тепло быстрее и в больших объемах, чем традиционные методы воздушного охлаждения. Поэтому жидкостное охлаждение может решить эти проблемы. Решение Lenovo Neptune®, согласно анализу Futurum, – лидер отрасли в области жидкостного охлаждения. Оно может поддерживать большую вычислительную мощность в традиционных серверных форм-факторах, поскольку очень эффективно поглощает тепло, а влияние площади поверхности на производительность резко снижается. Серверы с жидкостным охлаждением требуют меньше места, производят меньше шума и обеспечивают в целом более прохладную среду в ЦОДе.

Чем может грозить бизнесу отсутствие современных систем охлаждения?

Перегрев оборудования приводит к снижению производительности: процессоры и графические ускорители автоматически уменьшают частоту работы, чтобы снизить тепловыделение, а это замедляет выполнение задач, в том числе критически важных для бизнеса. При длительном воздействии высоких температур ускоряется износ комплектующих, что сокращает срок службы оборудования и вынуждает инвестировать в преждевременную замену серверов и систем хранения. Нестабильная работа из-за перегрева повышает риск аварийных простоев. Для компаний с непрерывным циклом обслуживания клиентов, таких как банки или онлайн-сервисы, это означает потерю выручки, серьёзные репутационные последствия. Например, даже кратковременная недоступность онлайн-банкинга или сбой в обработке платежей может привести к массовому оттоку клиентов и штрафам за нарушение условий SLA. Дополнительный фактор – рост затрат на обслуживание: устаревшие системы охлаждения требуют большего объёма технических работ и не позволяют эффективно масштабировать инфраструктуру. Кроме того, они потребляют больше электроэнергии*, это напрямую увеличивает операционные расходы и ухудшает показатели ESG. Для организаций, которые декларируют цели устойчивого развития, игнорирование этой проблемы влечёт репутационные риски и ограничивает доступ к определённым видам финансирования и партнёрств.

Решение - Lenovo Neptune®

Lenovo уже более двенадцати лет развивает технологию жидкостного охлаждения. Они первыми поставили суперкомпьютер петафлопсного класса с жидкостным охлаждением в Суперкомпьютерном центре им. Лейбница в 2012 году, который дебютировал на 4-м месте в списке 500 лучших суперкомпьютеров (www.top500.org). У Lenovo больше систем TOP500, чем у любого другого поставщика (по данным за июнь 2024 года). Девять из десяти самых быстрых систем Lenovo в списке TOP500 используют жидкостное охлаждение на базе Neptune®.

Основная идея технологии заключается в отводе тепла от центральных процессоров, графических ускорителей и других ключевых компонентов через замкнутый контур с теплоносителем, что позволяет утилизировать до 98% выделяемого тепла, значительно снизить нагрузку на системы воздушного охлаждения и уменьшить потребление энергии. Решение обеспечивает бесшумную высокую производительность при более низком энергопотреблении в компактном корпусе, поэтому клиенты могут достичь более высокой плотности размещения оборудования и большей производительности своего ЦОДа. В отличие от традиционного охлаждения, при котором тёплый воздух рассеивается по помещению и требует работы мощных кондиционеров, решение Lenovo удаляет тепло с высокой эффективностью и позволяет использовать более плотные и производительные конфигурации оборудования в тех же стойках. Это особенно важно для инфраструктур с несколькими графическими ускорителями в каждом сервере и большими объёмами памяти, где тепловыделение критично.

Применение Neptune® даёт бизнесу несколько ключевых преимуществ:

- Снижается энергопотребление ЦОД — часть тепла может использоваться повторно, например, для обогрева помещений, что уменьшает операционные расходы

- Сокращаются затраты на площадь и климатическое оборудование, поскольку повышается плотность установки оборудования без угрозы перегрева

- Повышается стабильность работы сервисов: оборудование функционирует в оптимальном температурном диапазоне, а риск аварийных остановок минимален

Технология Lenovo Neptune® оказалась незаменимой в поддержке наиболее приоритетных сценариев использования, включая инженерные, моделирующие, симуляционные рабочие нагрузки и производство анимационных фильмов, которые требуют вычислительной мощности на пиковой производительности. Например, Geely Auto выбрала Lenovo для развертывания локального кластера HPC [High Performance Computing, высокопроизводительные вычисления], чтобы избежать затрат и сложностей, связанных с облаком. Этот шаг принес немедленные выгоды, поскольку новый кластер увеличил производительность HPC на 35%, сократив при этом энергопотребление на 1 миллион кВтч/год.

Noventiq – партнер Lenovo

Noventiq имеет наивысший партнёрский статус Lenovo 360 Platinum ISG в Казахстане. Этот уровень подтверждает доступ к последним технологическим новинкам и инженерным ресурсам вендора, позволяет предлагать клиентам комплексную поддержку на всех этапах: от аудита инфраструктуры и выбора оптимальной конфигурации до внедрения и постпроектного сопровождения. Собственный Demo-фонд даёт возможность протестировать оборудование и конфигурации до закупки, что помогает избежать ошибок и снизить инвестиционные риски.

Команда Noventiq готова реализовать проекты любой сложности, включая интеграцию технологий ИИ, высокопроизводительных вычислений и модернизацию ЦОДов. Такой подход позволяет заказчикам как решать текущие задачи, так и формировать технологический задел для будущего роста.

Если ваша компания рассматривает модернизацию охлаждения или готовится к запуску ИИ-систем, наша команда готова подобрать оптимальное решение, протестировать его на вашем сценарии и обеспечить полный цикл внедрения. Свяжитесь с нами, чтобы обсудить, как сделать вашу инфраструктуру готовой к будущим нагрузкам.

Камил Ахтаров, BDM Lenovo Eastern Europe & Central Asia

Кроме того, они потребляют больше электроэнергии* — по данным Lawrence Berkeley National Laboratory, на охлаждение в ЦОДах уходит до 55% всей потребляемой энергии.